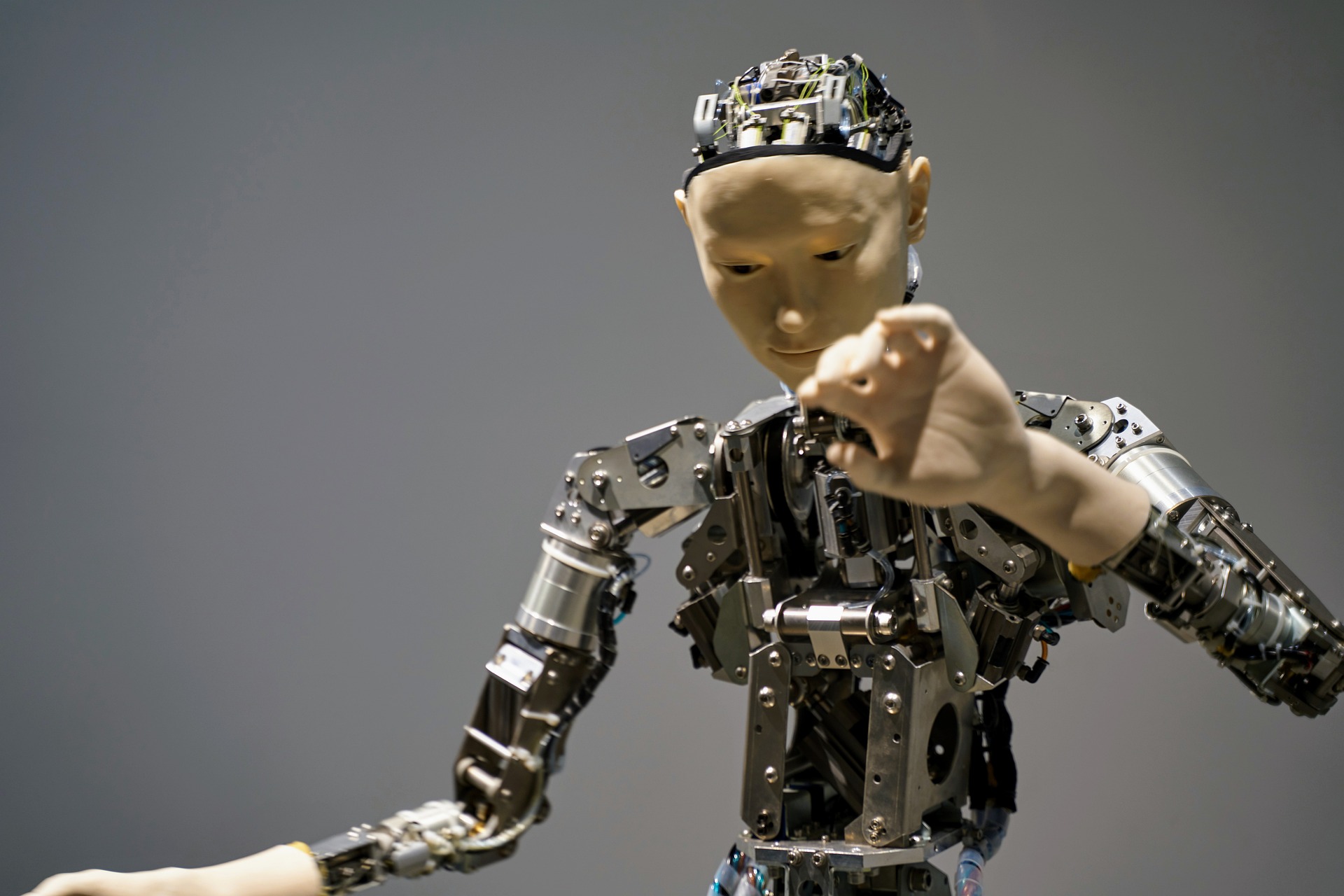

Изтъкнати лидери в областта на информационните технологии във вторник предупредиха, че технологията за изкуствен интелект (ИИ), която изграждат, може един ден да представлява екзистенциална заплаха за човечеството и трябва да се счита за обществен риск наравно с пандемиите и ядрените войни.

"Намаляване на риска от изчезване, причинено от ИИ, трябва да бъде глобален приоритет наред с други рискове от обществен мащаб, като пандемии и ядрена война“, се казва в изявление от едно изречение, публикувано от Центъра за безопасност на ИИ, организация с нестопанска цел и цитирано от "Ню Йорк таймс".

Отвореното писмо е подписано от повече от 350 ръководители, изследователи и инженери, работещи в областта на ИИ. Подписалите се включват висши ръководители от три от водещите компании: Сам Алтман, главен изпълнителен директор на OpenAI; Демис Хасабис, главен изпълнителен директор на Google DeepMind; и Дарио Амодей, главен изпълнителен директор на Anthropic.

Джефри Хинтън и Йошуа Бенгио, двама от тримата изследователи, които спечелиха наградата "Тюринг" за пионерската си работа върху невронните мрежи и често определяни като "кръстници" на модерния ИИ-движение, подписаха изявлението, както и други видни изследователи в областта.

Предупреждението идва в момент, когато растат опасенията относно опасностите, съпровождащи усъвършенстването на ИИ. Последните постижения в така наречените големи езикови модели - типът ИИ-система, използвана от ChatGPT и други чатботове - породиха опасения, че ИИ скоро може да се използва широкомащабно за разпространение на дезинформация и пропаганда. Той може да "изяде" огромно количество работни места на административния персонал.

Някои дори вярват, че в близките години ИИ може да стане достатъчно мощен, за да причини сътресения в обществен мащаб, макар че специалистите избягват да дадат отговор на въпроса кака конкретно може да се случи това.

Така разработващите подобна система се оказват в противоречивата позиция да предупреждават за последствията от самата нея и за нуждата от по-строги регулации спрямо нея заради потенциалните й вредни влияния.

Някои скептици твърдят, че ИИ технологията все още е твърде незряла, за да представлява заплаха за съществуването на човечеството. Когато става въпрос за днешни ИИ системи, те се тревожат повече за краткосрочни проблеми, като пристрастни и неправилни отговори, отколкото за по-дългосрочни опасности.

Други обаче твърдят, че този вид системи се подобрява толкова бързо, че вече е надминал производителността на човешко ниво в някои области и скоро ще го надмине в други. Те казват, че технологията е показала признаци на усъвършенствани възможности и разбиране, което поражда опасения, че "изкуственият общ интелект" или ИОИ - вид изкуствен интелект, който може да съвпадне или да надмине производителността на човешко ниво при голямо разнообразие от задачи - може би вече не е далеч от появяването си.

Няколко изпълнителни директори на водещи разработчици на ИИ вече предложиха някои мерки за отговорно управление на такива системи: сътрудничество между водещите разработчици на ИИ; повече проучвания в областта на големите езикови модели и създаване на международно ИИ организация за безопасност.

През март повече от 1 000 технолози и изследователи подписаха друго отворено писмо, призоваващо за шестмесечна пауза в разработването на най-големите ИИ-модели, позовавайки се на опасения относно "излизаща извън контрол надпревара за разработване и внедряване на все по-мощни цифрови умове“.

Това писмо, което беше инициирано от Future of Life Institute - друга организация с нестопанска цел, фокусирана върху ИИ, беше подписано от Илон Мъск и някои добре известни технологични лидери, но нямаше много подписи от водещите лаборатории за разработване на ИИ. Новото предупреждение, само от 22 думи на английски, достигна до част от тези лаборатории, където някои от служителите го подписаха.

Предупрежденията стават все по-настойчиви, защото все повече хора се обръщат към ИИ-чатботовете за разговор, компания и повишена производителност, а стоящата зад това технология се развива с много бързо темпо.