Милиардерът Илон Мъск и редица експерти призоваха за спиране на разработването на мощни системи за изкуствен интелект (ИИ), за да се осигури време за проверка на тяхната безопасност, предаде АФП. Отвореното писмо, подписано до момента от над 1 000 души, сред които Мъск и съоснователят на Apple Стив Возняк, беше предизвикано от пускането на GPT-4 от подкрепяната от Microsoft фирма OpenAI.

Компанията твърди, че нейният последен модел е много по-мощен от предишната версия, която е била използвана за ChatGPT.

"Системите за изкуствен интелект с конкурентен на човешкия интелект могат да създадат дълбоки рискове за обществото и човечеството", се казва в отвореното писмо, озаглавено "Спиране на гигантските експерименти с изкуствен интелект."

"Мощни системи с ИИ трябва да се разработват само след като сме сигурни, че ефектът от тях ще бъде положителен, а рисковете - управляеми", гласи още писмото.

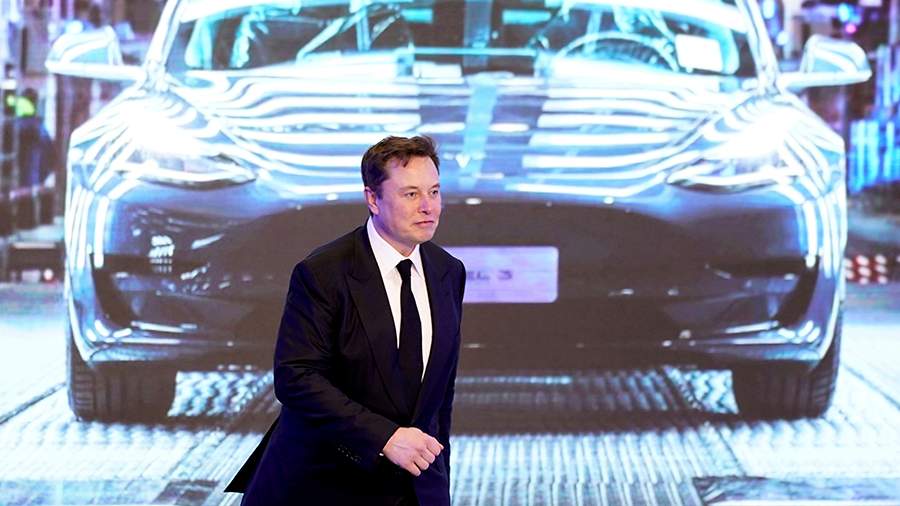

Мъск беше първоначален инвеститор в OpenAI, прекара години в нейния управителен съвет, а неговата автомобилна компания Tesla разработва системи за ИИ, които помагат за захранването на технологията за самоуправление, наред с други приложения.

Писмото, организирано от финансирания от Мъск Институт за бъдещето на живота, беше подписано от известни критици, както и от конкуренти на OpenAI като шефа на Stability AI Емад Мостак. Канадският пионер в областта на изкуствения интелект Йошуа Бенгио, също подписал документа, на виртуална пресконференция в Монреал предупреди, че "обществото не е готово" за този мощен инструмент и за възможните му злоупотреби.

"Нека забавим темпото. Нека се уверим, че сме разработили по-добри предпазни средства", каза той и призова за задълбочена международна дискусия за ИИ и неговите последици, "както направихме за ядрената енергия и ядрените оръжия."

В писмото се цитира блог, написан от основателя на OpenAI Сам Алтман, който предполага, че "в определен момент може да е важно да се получи независим преглед, преди да се започне обучението на бъдещите системи".

"Съгласни сме. Този момент е сега", пишат авторите на отвореното писмо, "Ето защо призоваваме всички лаборатории за ИИ незабавно да преустановят поне за 6 месеца обучението на системи за ИИ, които са по-мощни от GPT-4."

Те призовават правителствата да се намесят и да наложат мораториум, ако компаниите не се съгласят.

Шестте месеца трябва да се използват за разработване на протоколи за безопасност, системи за управление на ИИ и пренасочване на научните изследвания към осигуряване на по-точни, безопасни, "надеждни и лоялни" системи на ИИ.

В писмото не се посочват подробности за опасностите, разкрити от GPT-4, но изследователите, сред които Гари Маркъс от Нюйоркския университет, подписал писмото, отдавна твърдят, че чатботовете са големи лъжци и имат потенциала да бъдат суперразпространители на дезинформация.

Авторът Кори Доктороу обаче сравни индустрията на изкуствения интелект със схема за "изпомпване и изхвърляне", твърдейки, че както потенциалът, така и заплахата от системите за изкуствен интелект са силно преувеличени.